DEDUPLICACIÓN & COMPRESIÓN

El descontrolado crecimiento de datos de nuestros usuarios provoca más de un dolor de cabeza a los administradores de sistemas de nuestras empresas. Además, el alto precio de los discos duros no ayuda en absoluto a poder solucionar este problema. Por este motivo, cada vez más fabricantes de arreglos de discos y de servidores, incorporan en sus catálogos esa opción de deduplicación y compresión.

¿QUÉ SON Y CÓMO AFECTAN A TU DATACENTER?

Compresión

Es el proceso de reducción de tamaño de cada elemento de datos, mediante algoritmos especiales. No todos los datos pueden ser comprimidos, tal es el caso del audio y el vídeo. Sin embargo, el texto se comprime perfectamente. El desafío es que no hay ninguna manera de averiguar exactamente como los datos van a ser comprimidos hasta que no lo sean realmente.

Existen dos modos de comprimir los datos de tu datacenter:

- In-line Compression o Compresión en tiempo real

- Post-Process Compression o Compresión diferida

In-line Compression o Compresión en tiempo real

⇒Requiere de una gran cantidad de CPU.

⇒Puede conducir a un proceso que consume bastante tiempo en la CPU, generando una reducción en el número total de IOPS disponibles para la aplicación.

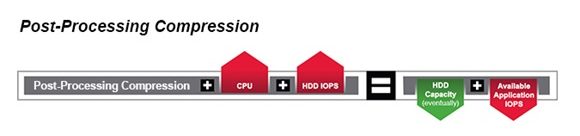

Post-Process Compression o Compresión diferida

⇒Primero escribe los datos en el disco y más tarde volverá a leer los datos para iniciar el proceso de compresión.

⇒Se requieren IOPS adicionales a la primera escritura para ser leídos y comprimidos.

⇒Se requiere de CPU después de la primera escritura y para el proceso de compresión.

⇒Se requieren más IOPS en los discos para la escritura una vez los datos son comprimidos.

⇒Reducimos el espacio de disco necesitado.

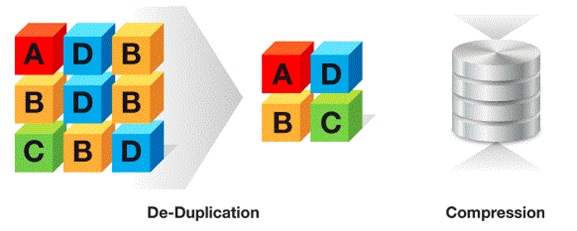

Deduplicación

La deduplicación es una técnica especial de optimización de datos para eliminar copias duplicadas o repetidas de datos con el objetivo de optimizar al máximo el espacio de almacenamiento utilizado. Los chunks (o pedazos de datos) son identificados y guardados durante el proceso de análisis. Muchos sistemas deduplican en alguna fase del ciclo de vida de los datos. Por definición, la deduplicación ocurre después de algún evento. Existen dos tipos:

- Deduplicación online o deduplicación en tiempo real

- Post-Process Deduplication o Deduplicación diferida

Inline Deduplication o Deduplicación en tiempo real

⇒Conlleva una penalización del rendimiento en todas les operaciones E/S. Necesita recursos dedicados de CPU y de memoria.

⇒Los datos primero son escritos por la aplicación al servidor y después son tratados. Finalmente, transferidos a la SAN o discos locales.

⇒Sistema de Backup: los datos primero son escritos al servidor/almacenamiento, previo a ser copiados y deduplicados al dispositivo de respaldos.

⇒Desde su inicio se reducirá el espacio necesario en disco.

⇒Puede conducir a un proceso que consume bastante tiempo en la CPU, generando una reducción en el número total de IOPS disponibles para la aplicación.

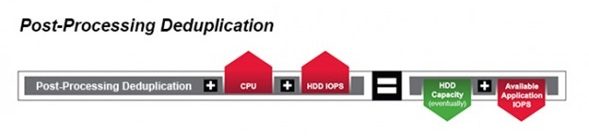

Post-Process Deduplication o Deduplicación diferida

⇒Primero los datos son escritos en disco y se programa una tarea para que a una hora en concreto, todos los datos escritos entre tarea y tarea, sean deduplicados.

⇒Requiere de espacio suficiente para mover los datos durante el proceso de deduplicación

⇒Necesita IOPS adicionales para leer todos los datos nuevos, deduplicar y finalmente volver a escribir los datos deduplicados.

Hiperconvergencia SimpliVity

SimpliVity es el único fabricante del mercado capaz de aprovechar las ventajas de la deduplicación y la compresión de los datos en tiempo real y sin penalizar el más mínimo rendimiento del sistema. Y todo es posible gracias al diseño de una solución basada en una tarjeta aceleradora llamada Omnistack Accelerator Card en conjunto con su software de administración global.

Con SimpliVity un bloque de datos es escrito, comprimido y optimizado una única vez y nunca más volverá a ser reescrito o duplicado en el sistema y en toda la federación. Así se garantiza una máxima eficiencia de datos a todos los niveles de rendimiento (DRAM, Flash/SSD y HDD).